이전 글에서 나는 "다음 글에서는 Maximum Mean Discrepancy 와 Wasserstein distance에 대해 정리하도록 하겠다." 고 당차게 말했지만.. 와 Wasserstein distance라는 게 엄청나게 수학적 개념, 특히 확률에서 출발한 방법이더라. 확률에 대한 감이 어느정도 잡히고 나서야 제대로 이해할 수 있겠다는 생각이 들었다. 그러려면 단시간에는 불가능하니... 우선 Maximum Mean Discrepance (MMD)에 대해서만 정리하고자 한다.

Maximum Mean Discrepancy (최대 평균 불일치)

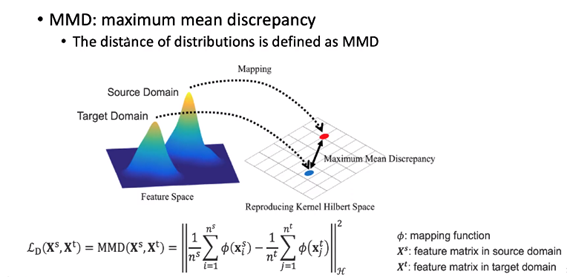

MMD도 두 데이터 분포 사이의 차이를 측정하는 방법이고, 그림에 나와있는 수식처럼 차이를 계산한다. 평균하고 빼고 제곱한 결과가 MDD 값이다. 무얼 평균? 각 domain으로부터 mapping 된 feature들을 평균한다.

내가 이해한 내용을 CNN을 예로 들어 적어보자면, CNN은 수식에서 mapping function에 해당되고 Source domain과 Target domain은 CNN의 Input에 해당된다. 각 domain의 데이터를 CNN에 넣으면 일련의 convolution 연산을 거쳐 feature map가 계산된다. 각 domain으로부터 계산된 feature map들을 먼저 평균한 다음, 그 결과를 차 연산하고, 그걸 또 제곱하면 최종적으로 MMD 값을 얻을 수 있다.

MMD도 물론 이것도 제대로 이해하려고 하면 한도 끝도 없이 깊어지는 개념이지만... 그래도 '아! 이거군!'하는 감은 잡을 수 있었는데, '와서스테인 거리'라 부르는 Wasserstein distance가 어렵다. 논문의 다른 내용들을 먼저 정리한 다음에, 확률 공부도 하고서 다시 시작하도록 하자.

< 참고 사이트 >

https://m.blog.naver.com/PostView.naver?isHttpsRedirect=true&blogId=ollehw&logNo=222090636083

Learning with Small Data

데이터 분석에 있어서 영원한 난제가 있습니다. 그것은 바로 적은 데이터로부터 학습을 하는 것이지요. 예...

blog.naver.com

https://blog.lunit.io/2017/04/27/style-transfer/

Style Transfer

Introduction Style transfer란, 두 영상(content image & style image)이 주어졌을 때 그 이미지의 주된 형태는 content image와 유사하게 유지하면서 스타일만 우리가 원하는 style image와 유사하게 바꾸는 것을 말합

blog.lunit.io