논문 링크

블랙 박스 문제는 의료 영역 뿐만 아니라 모든 영역에서나 인공지능 출력 분석에 발목을 잡는다. 그래서 '해석 가능한 인공지능 (XAI, Explainable AI)' 이라는 주제로 여러 시도들이 연구되어 왔다. 방법론들을 정리한 리뷰 논문까지 있을 만큼 다양한 관점에서 많은 시도들이 이루어지고 있는 연구분야이다. 그 중에서 유명한 방식으로 Grad-CAM이 있고, 의료 인공지능 에서는 이 Grad-CAM을 '이상 소견이 위치해 있는 곳'으로 해석하고자 하는 (or 바라보는) 연구들이 많이 진행됐다.

※ 여기서 잠깐 용어하고 개념에 대해 정리 한 번 하고 넘어가자. (내 개인적인 생각)

(1) XAI 중 Gradient-based method로 Saliency map, CAM, Grad-CAM, Grad-CAM++이 있다.

(2) saliency map이 gradient-based로 가장 처음 제안된 방식이라 gradiend-based = saliency map으로 인식됨

(3) Saliency map에서 발전된 CAM도 유명해지다 보니까 gradiend-based = saliency map = cam으로 인식되기 시작

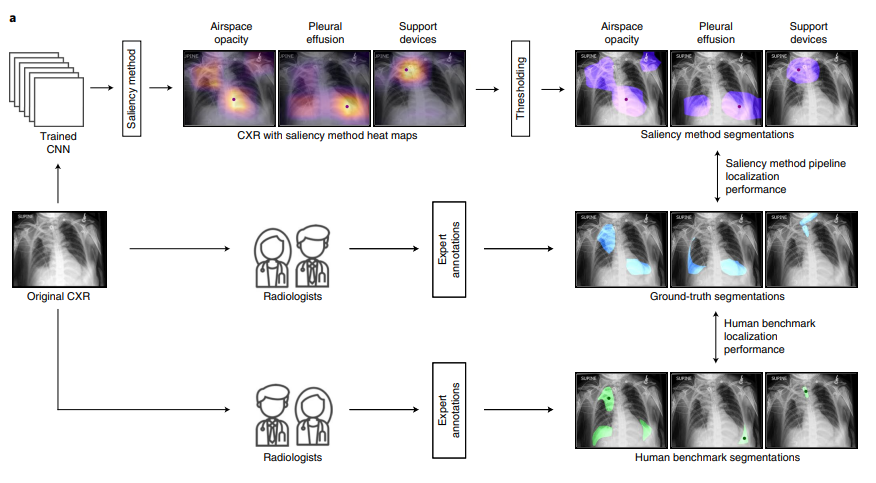

오늘 리뷰하려고 하는 논문에서는 Saliency method가 CXR의 실제 이상 소견 위치를 가리키는 지에 대한 엄밀한 조사가 필요하다고 지적하며 직접 실험을 통한 검증을 진행한다. 이를 위해 본 논문에서는 의사가 직접 annotation한 mask 영상과 여려가지 saliency method들의 결과를 비교하는 연구를 진행했다.

저자는 아래의 실험 결과들을 토대로 "~, suggesting that deep learning explainability as a clinical interface may be less reliable and less useful when used for pathologies with these characteristics"라고 말한다.

- 특히 이상 소견의 ground-truth이 작거나 복잡한 모양을 하고 있으면 더 취약한 성능을 보임

- 9개 이상 소견에 대한 Hit rate 평가를 진행했는데 7개 소견에서 grad-cam의 성능이 매우 떨어짐

- mIoU 평가를 진행했을 때 atelectasis랑 consolidation에서 더 좋은 성능을 보이긴 했는데, 해당 이상 소견들은 다른 소견들에 비해 비교적 덜 중요한 소견들.

→ 저자는 Grad-CAM이 보통 14x14 size로 생성되는데 이를 2000x2000으로 늘리다보니 어쩔 수 없이 이러는 게 아닌가 생각한다고 함 - 긍적적인 부분은 입력 CXR에 대한 model의 confidence score가 높으면 grad-cam의 localization performance 또한 비교적 잘 나옴.

또한 저자는 이런 말도 했다. If used in clinical practice, heat maps that incorrectly highlight medical images may exacerbate well documented biases (chiefly automation bias) and erode trust in model predictions (even when model output is correct), limiting clinical translation. 모델이 분류를 잘해도 엉뚱한 곳을 가리키고 있으면 신뢰도를 잃어 버린다. 중요한 지적인 것 같다.

'Grad-CAM을 통한 Heatmap을 이상 소견 위치로 줘도 되는 건가? 임상적으로 가능해?' 하던 궁금증을 실험적으로 해결해준 논문이다. 그리고 model output 값이 높으면 그나마 grad-cam도 얼추 잘 잡는 것 같단 생각이 맞았음을 확인시켜준 논문이다. Lesion-level annotation의 어려움, 비용 문제 등에서 벗어나고자 saliency map의 가능성을 열어두고 많은 연구들이 진행되었지만 아직은 supervised-learning의 범주를 벗어나지 못하나 보다.

< 참고 사이트 >

https://hchoi256.github.io/xai/XAI-saliency/

https://velog.io/@tobigs_xai/3%EC%A3%BC%EC%B0%A8-XAI-survey-paper-review-2